AN THỊNH - GIÁ TRỊ PHONG THỦY ĐÍCH THỰC CỦA BẠN !!

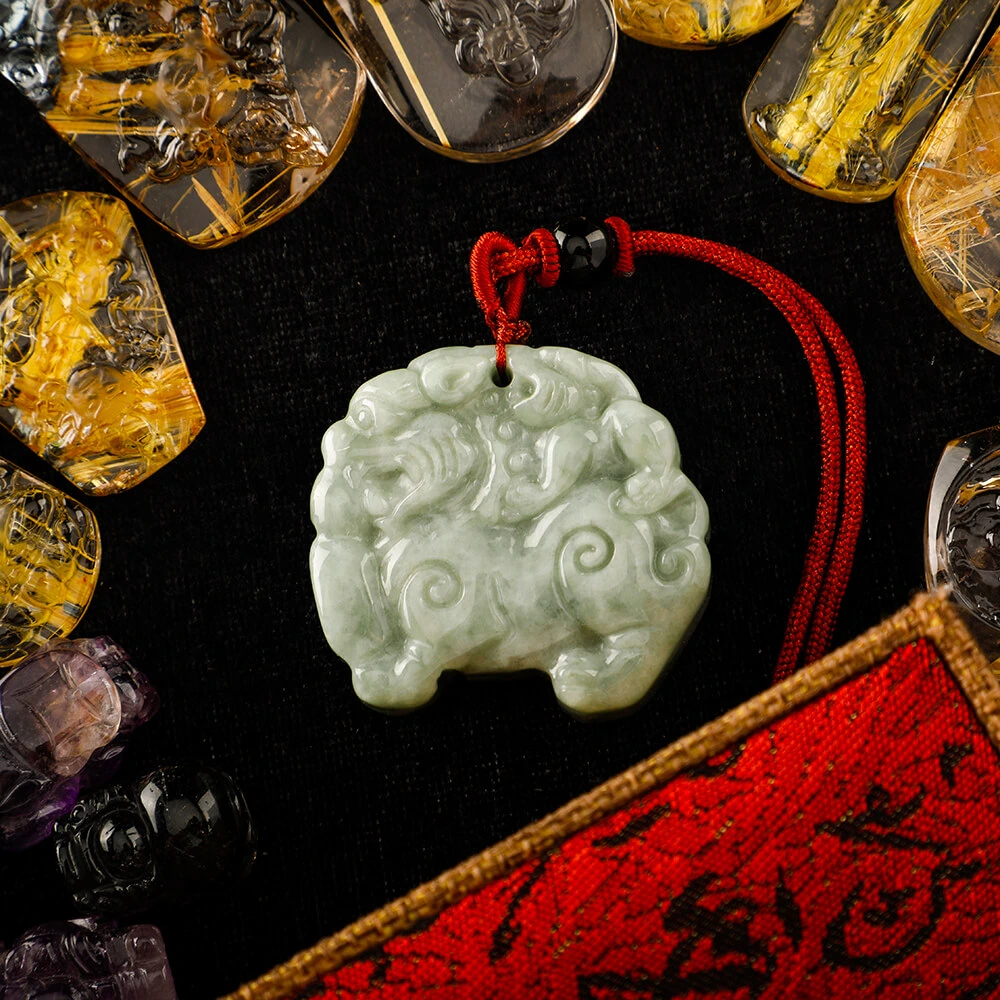

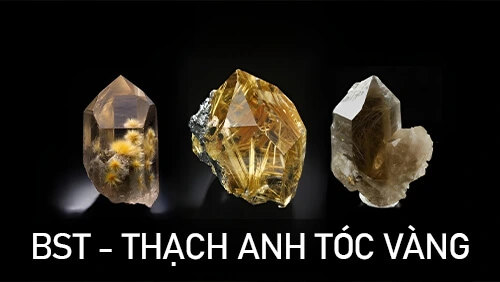

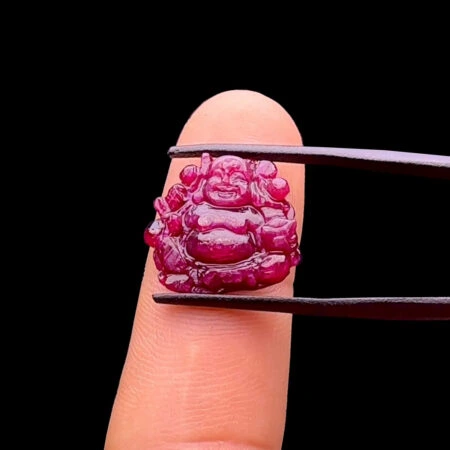

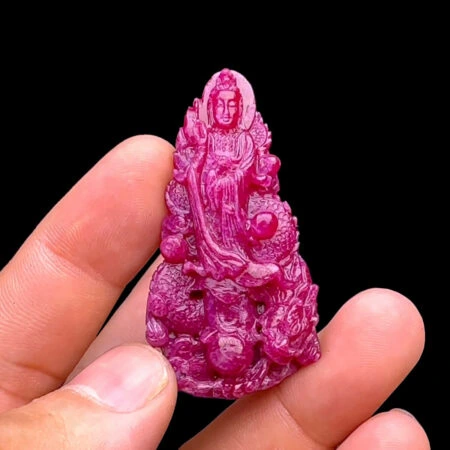

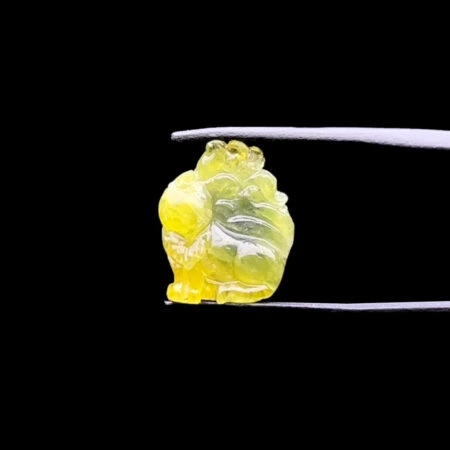

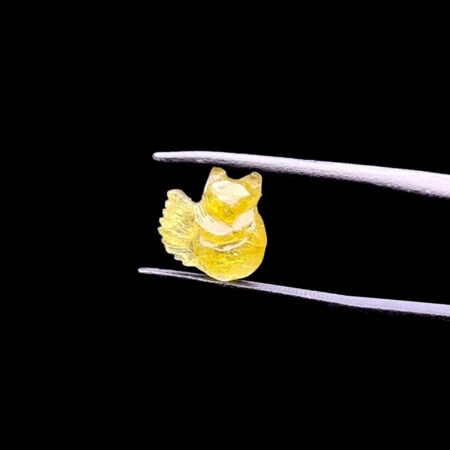

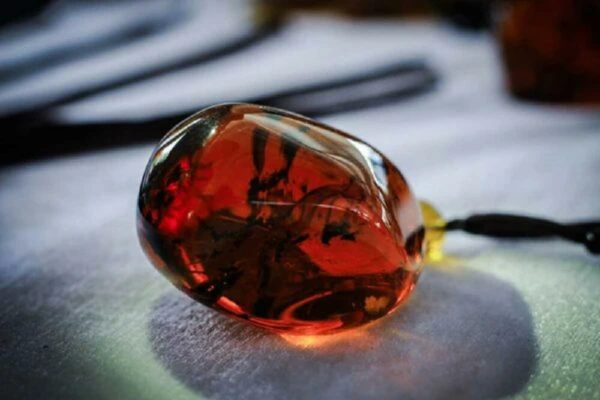

Với hơn 5 năm kinh nghiệm trong ngành Đá Quý – Infinity Gems An Thịnh tự hào là một trong nhưng nơi quý khách có thể tin tưởng tìm mua các loại vật phẩm phong thủy – Trang sức với chất lượng tốt nhất cùng giá cả cạnh tranh. Cam kết chỉ kinh doanh đá tự nhiên 100% và sẵn sàng bồi thường gấp nhiều lần giá trị nếu phát hiện hàng giả. Sản phẩm phải đảm bảo nhu cầu thẫm mỹ khắt khe nhất của một người yêu đá quý và được kiểm định chặt chẽ về chất lượng thông qua một trong các trung tâm nổi tiếng như: SJC, PNJ, Liulab …